Le deepfake n’est plus une curiosité technologique réservée aux laboratoires de recherche ou aux studios de cinéma. En l’espace de quelques années, il est devenu un outil accessible, industrialisable et parfois exploité à grande échelle. Cette évolution rapide pose une question centrale : celle de la confiance dans le numérique.

En brouillant la frontière entre ce qui est réel et ce qui est généré artificiellement, le deepfake ne menace pas seulement la sécurité informatique. Il remet en cause notre capacité collective à croire ce que nous voyons, ce que nous entendons et ce que nous pensons authentique.

Une technologie devenue accessible et industrialisable

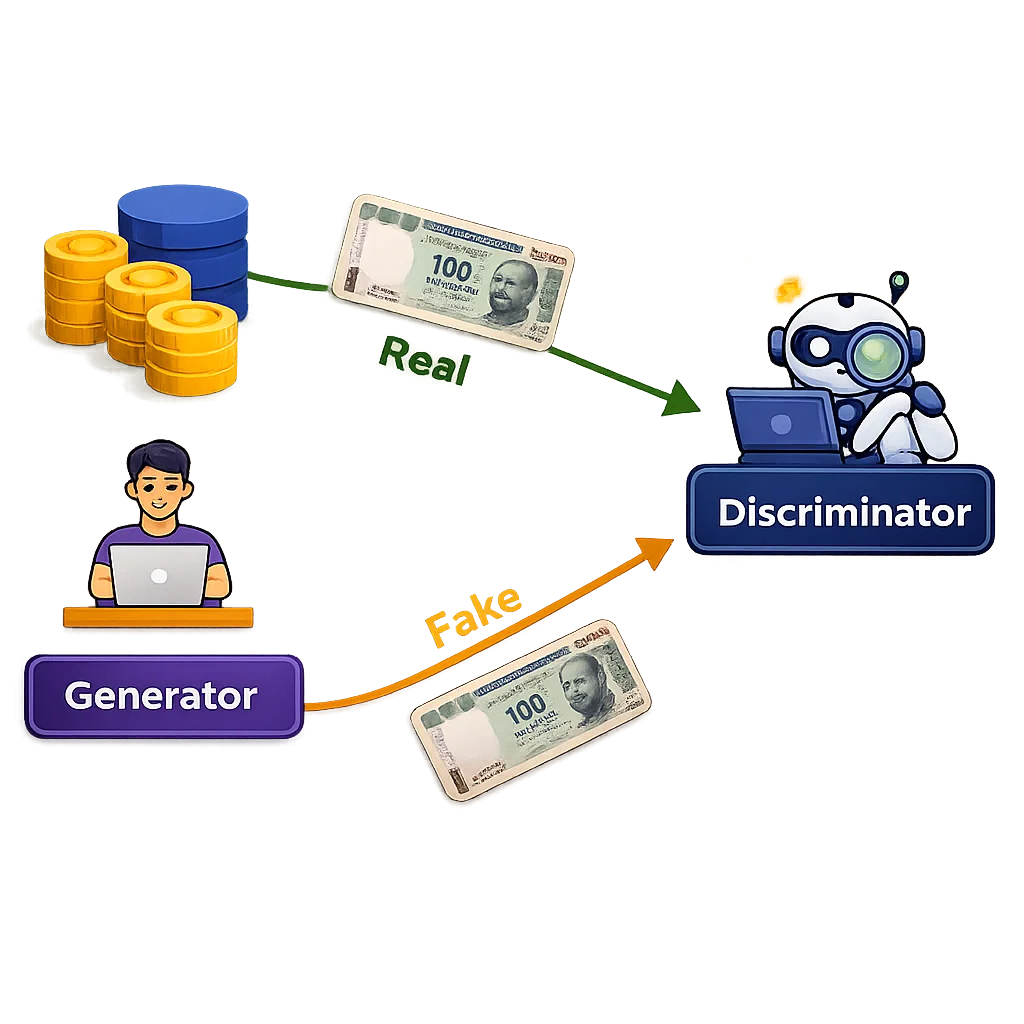

Techniquement, les deepfakes reposent sur des avancées majeures en intelligence artificielle, notamment les réseaux antagonistes génératifs (GAN), les modèles de diffusion et les modèles neuronaux de clonage vocal. Ces technologies permettent de générer des visages, des expressions, des mouvements et des voix avec un réalisme qui progresse à une vitesse impressionnante.

Ce qui a profondément changé ces dernières années, ce n’est pas uniquement la qualité des résultats, mais leur accessibilité. Là où il fallait autrefois des compétences pointues en machine learning, des volumes importants de données et une puissance de calcul conséquente, il est aujourd’hui possible de produire un deepfake crédible avec des outils open source relativement simples à prendre en main.

Des logiciels comme DeepFaceLab ou FaceFusion permettent le remplacement de visages dans des vidéos avec un minimum de paramétrage. Des solutions comme Roop facilitent encore davantage ce type de manipulation. Côté audio, des technologies comme RVC (Retrieval-based Voice Conversion) rendent possible le clonage vocal à partir de quelques minutes d’enregistrement. Couplés à des outils de synchronisation labiale comme Wav2Lip ou SadTalker, ces systèmes permettent d’obtenir un rendu cohérent entre la voix et le visage.

Le véritable point de bascule réside toutefois dans le deepfake en temps réel. En combinant ces modèles avec des outils de diffusion comme OBS, il devient possible de se présenter en visioconférence avec un visage et une voix qui ne sont pas les siens, et d’interagir de manière fluide avec des interlocuteurs humains. À ce stade, le deepfake n’est plus une simple vidéo truquée : il devient une présence artificielle crédible.

Quand le deepfake devient une arme : fraudes, chantage et désinformation

Cette démocratisation technologique a naturellement entraîné une explosion des usages malveillants. Le monde de l’entreprise a été l’un des premiers touchés. En 2024, une multinationale basée à Hong Kong a perdu plus de 25 millions de dollars après une visioconférence avec ce qu’elle pensait être son directeur financier et plusieurs collègues. L’enquête a révélé que tous les participants visibles à l’écran, à l’exception de la victime, étaient des deepfakes générés par intelligence artificielle. Le visage, la voix et les interactions étaient suffisamment crédibles pour convaincre un collaborateur de procéder à des transferts financiers urgents. Ce cas, documenté par CNN et la police de Hong Kong, illustre parfaitement une nouvelle forme de fraude : il ne s’agit plus de pirater un système, mais de manipuler un humain en exploitant la confiance accordée à la visioconférence et à l’autorité hiérarchique.

Sources CNN : Liens vers l’article.

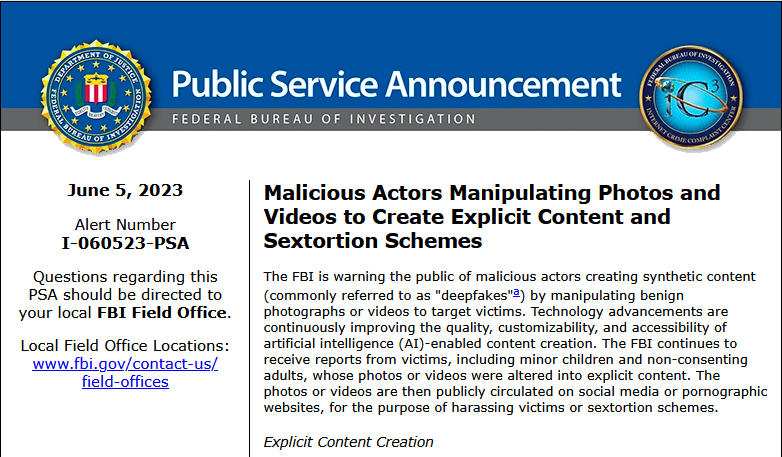

Les usages criminels ne se limitent pas au monde professionnel. Depuis 2023, le FBI alerte sur une augmentation massive des cas de sextorsion impliquant des deepfakes. Des images publiques, souvent récupérées sur les réseaux sociaux, sont utilisées pour générer des contenus sexuels non consentis visant aussi bien des adultes que des mineurs. Ces contenus servent ensuite à exercer un chantage financier ou psychologique. Une fois diffusées, ces images sont extrêmement difficiles à faire disparaître, même avec l’intervention des plateformes.

Le champ politique et institutionnel est également touché. En 2022, un faux discours de reddition attribué à Volodymyr Zelensky a été diffusé sur une chaîne ukrainienne piratée, avant d’être rapidement démenti par les autorités. En janvier 2024, un deepfake vocal imitant Joe Biden a appelé des électeurs du New Hampshire à ne pas voter lors des primaires, une affaire largement relayée par le New York Times et l’Associated Press. En France, une fausse vidéo imitant un reportage de France 24 a circulé en février 2024, annonçant une tentative d’assassinat du président Emmanuel Macron. Dans tous ces cas, le même mécanisme est à l’œuvre : le doute s’installe avant même que le démenti ne puisse produire ses effets.

Des usages légitimes et bénéfiques

Réduire le deepfake à ses usages criminels serait toutefois une erreur. La technologie possède également des applications légitimes, encadrées et parfois bénéfiques. Dans l’industrie du cinéma, des techniques assimilées au deepfake sont utilisées pour rajeunir des acteurs ou recréer des personnages disparus. Le film The Irishman a ainsi utilisé des technologies avancées pour rajeunir Robert De Niro et Al Pacino. Dans Indiana Jones and the Dial of Destiny, Harrison Ford apparaît rajeuni de plusieurs décennies dans certaines scènes. Dès 2016, Rogue One: A Star Wars Story avait déjà suscité des débats en recréant numériquement l’acteur Peter Cushing.

Le jeu vidéo explore également ces technologies. Les moteurs actuels permettent de créer des personnages non joueurs capables de dialoguer de manière dynamique, avec des visages et des voix générés par IA. Des démonstrations internes montrent déjà des joueurs interagissant verbalement avec des personnages incarnés par des acteurs de cinéma, reproduisant leur apparence et leur voix. À terme, il pourrait devenir possible de dialoguer en temps réel avec un héros de film ou de jeu vidéo de son enfance, soulevant des questions éthiques et juridiques inédites autour du consentement, de la licence et de l’exploitation de l’image.

Dans le domaine du handicap, les bénéfices sont très concrets. L’exemple le plus emblématique reste celui de Val Kilmer. Après avoir perdu l’usage de sa voix à la suite d’un cancer de la gorge, une intelligence artificielle a été entraînée à partir de ses archives vocales pour recréer une voix synthétique fidèle à la sienne. Cette technologie lui permet de s’exprimer à nouveau publiquement, sans recourir à une voix générique artificielle. Des dispositifs similaires sont utilisés par des patients atteints de maladies neurodégénératives, de séquelles d’AVC ou de troubles sévères de la communication.

Le deepfake peut également jouer un rôle protecteur. Le documentaire Welcome to Chechnya a utilisé cette technologie pour masquer l’identité de témoins LGBTQ+ persécutés, tout en conservant leurs expressions faciales et l’émotion de leurs témoignages. Dans ce contexte, le deepfake devient un outil de protection et de liberté d’expression, fondé sur le consentement et la transparence.

Détection, OSINT et traçabilité : des réponses encore imparfaites

Face à la montée des deepfakes, de nombreux outils de détection ont émergé, notamment dans les milieux journalistiques et OSINT. Des solutions comme InVID permettent d’analyser des vidéos, d’extraire des images clés et de mener des recherches inversées. Des moteurs comme Google Images ou Yandex sont régulièrement utilisés pour identifier des images sources.

Ces outils restent toutefois limités. Les modèles les plus récents génèrent des images et des vidéos pixel par pixel, sans laisser de traces exploitables. Dans de nombreux cas, il n’existe tout simplement plus d’anomalies visibles ou de métadonnées suspectes à analyser. La détection purement technique atteint ainsi ses limites.

C’est pourquoi une autre approche gagne du terrain : certifier le réel plutôt que traquer le faux. Des initiatives comme la norme C2PA, portée par Adobe, Microsoft, Google et Intel, visent à intégrer des métadonnées certifiant l’origine et l’historique d’un contenu dès sa création. Les Content Credentials d’Adobe permettent déjà de vérifier publiquement la provenance de certaines images. Ces solutions restent néanmoins imparfaites, car les métadonnées peuvent être supprimées et leur adoption n’est pas encore généralisée.

Un cadre juridique en construction, mais toujours en retard

Sur le plan juridique, les États tentent de rattraper leur retard. En France, la loi LSREN de 2024 a créé un délit spécifique de deepfake, avec des sanctions renforcées lorsque les faits sont commis en ligne ou à caractère sexuel. Au niveau européen, l’AI Act impose des obligations de transparence pour les contenus générés par intelligence artificielle. À l’international, les réponses restent hétérogènes, certains pays adoptant des cadres très stricts, d’autres beaucoup plus permissifs.

Dans tous les cas, le constat est le même : le droit progresse, mais toujours après l’innovation technologique.

Conclusion : apprendre à douter, s’informer et adapter nos réflexes

La véritable question n’est donc plus de savoir si cette technologie est possible, mais comment nous apprenons à vivre avec elle.

C’est précisément dans cette démarche que s’inscrit Ventury Technology. Notre valeur ajoutée ne réside pas uniquement dans la mise en conformité ou la réponse à incident, mais aussi et surtout dans l’enseignement, la sensibilisation et la veille permanente sur les nouvelles menaces cyber, comme le deepfake, et sur les moyens concrets d’y faire face. Grâce à ce travail de fond, mené en continu, et à notre capacité à transmettre des sujets complexes de manière simple, claire et engageante, nous accompagnons chaque jour des PME pour leur permettre de ne pas se faire piéger et de rester à jour face à un paysage de menaces en perpétuelle mutation.